«Er arbeitet hart, sie ist faul»

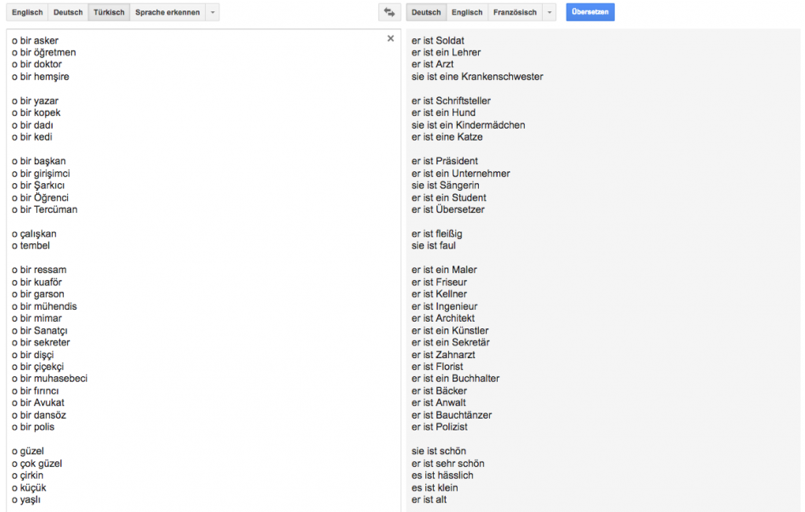

Facebook-User Emre Sarbak, der in den USA lebt und in der IT-Branche arbeitet, hat türkische Sätze mit dem Übersetzungs-Roboter ins Englische übersetzt. Dabei hat er festgestellt, dass geschlechtsneutrale Sätze nach der Übersetzung klischeehaft werden. Im Türkischen gibt es nur das Personalpronomen o. Die Bezeichnungen «er», «sie» und «es» existieren also nicht. Der Satz «o çalışkan» heisst er/sie/es arbeitet hart. Google Translate aber übersetzt: Er arbeitet hart. «o tembel» heisst er/sie/es ist faul. Google übersetzt: Sie ist faul.

Sie ist Krankenschwester, er ist Arzt

Der Übersetzungs-Roboter passt das türkische o bei der Übersetzung ins Englische dem Geschlecht an, das aufgrund ’objektiver’ Algorithmen am besten passt und zementiert damit klischeehafte Vorurteile. Bei der Übersetzung vom Türkischen ins Deutsche geschieht Ähnliches, berichtet das Online-Portal «ze.tt». Hier übersetzt Google: Er ist fleissig, sie ist faul. Während sie nur Krankenschwester, Kindermädchen oder Sängerin sein darf, ist er Lehrer, Arzt, Schriftsteller, Präsident, Polizist, Unternehmer und sogar Florist. Wenigstens ist sie optimistisch und er pessimistisch. Laut der Online-Plattform «Quartz» kommt es auch bei der Übersetzung vom Türkischen in weitere Sprachen wie Chinesisch, Estländisch und Finnisch zu ähnlichen Klischees.

’Objektiver’ Algorithmus übersetzt klischeehaft

Grund für die klischeehaften Übersetzungen sind die ’objektiven’ Algorithmen, auf denen der Übersetzungs-Roboter basiert. Sie berechnen aufgrund eines riesigen Datenmaterials, welches Personalpronomen am häufigsten benutzt wird. Wird das Wort Arzt häufiger in der männlichen Form gesucht, lernt der Algorithmus, dass der Arzt männlich ist. Den geschlechtsneutralen Satz «O bir doktor» übersetzt der Roboter deshalb mit «er ist Arzt». Damit reproduziert der Übersetzungs-Roboter die Vorurteile in der Gesellschaft. Emre Sarbak: «Es ist unglaublich, dass ein ’objektiver’ Algorhitmus sexistisch übersetzt, nur weil er auf klischeehaften Daten beruht.»

Themenbezogene Interessenbindung der Autorin/des Autors

keine